AI Hallucinations, Sanciones y Contexto: Lo que un Caso Disciplinario de Florida Realmente Enseña

No hay duda de que la inteligencia artificial ofrece un gran potencial para el trabajo legal de alto nivel. Desde la disponibilidad generalizada de la IA generativa, académicos legales, tecnólogos y desarrolladores de productos han demostrado cómo estas herramientas, cuando se utilizan correctamente, pueden mejorar el rendimiento humano. La IA es excelente para acceder, organizar y procesar enormes volúmenes de información; los abogados y jueces aportan juicio, experiencia, empatía y responsabilidad ética. Usados juntos, la combinación puede ser extraordinariamente efectiva.

Sin embargo, muchos profesionales ocupados han pasado por alto una verdad obvia y severa: la IA puede estar equivocada; el usuario humano sigue siendo plenamente responsable; y la verificación no es opcional. Los abogados responsables deben verificar cada cita y afirmación en un documento judicial contra fuentes originales y autorizadas. No hay atajo para esa obligación.

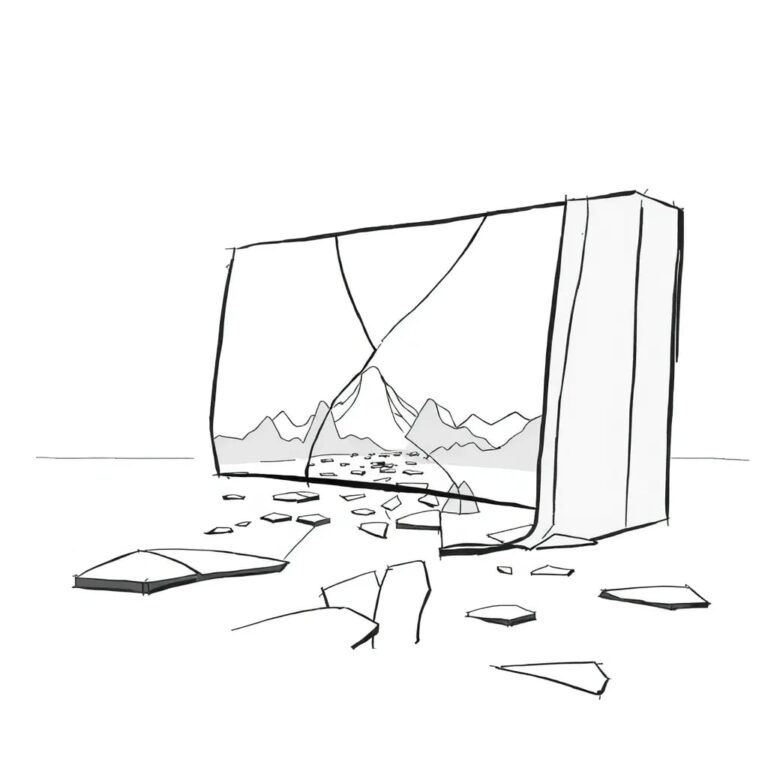

El incumplimiento de esta disciplina básica ha generado un creciente número de casos que involucran «alucinaciones» de IA, es decir, citas y afirmaciones fabricadas o inexactas que aparecen en presentaciones judiciales. A pesar de la publicidad generalizada, advertencias judiciales, orientación ética y sanciones, el problema no ha disminuido.

Una base de datos mantenida públicamente que rastrea decisiones judiciales relacionadas con alucinaciones generadas por IA informa más de 500 de tales casos en los tribunales de Estados Unidos hasta el momento de escribir esto. Los tribunales, enfrentando violaciones repetidas, han escalado las sanciones en un esfuerzo por disuadir esta conducta. Lo que comenzó con advertencias, reprimendas y sanciones monetarias ha progresado, en algunos casos, a la descalificación de representación, divulgación obligatoria de órdenes de sanción a clientes y tribunales, y referencias a autoridades disciplinarias.

El Caso en Contexto

El caso de disciplina no es un ejemplo limpio de un error aislado de IA que escaló en suspensión. La orden del tribunal es breve y mayormente procedural; la queja del colegio de abogados y el informe del árbitro proporcionan los hallazgos sustantivos. Esos materiales describen a un abogado que ignoró repetidamente órdenes judiciales, reafirmó argumentos ya rechazados por el tribunal, tergiversó la autoridad legal y no corrigió citas fabricadas incluso después de que las deficiencias fueron identificadas por el abogado opositor.

Las citas alucinadas corroboraron una conducta más amplia; no la definieron. El registro refleja un patrón sostenido de mala conducta. Además de citas inexactas y fabricadas, el árbitro encontró violaciones repetidas de reglas locales, etiquetado incorrecto de presentaciones, intentos inapropiados de volver a litigar cuestiones jurisdiccionales y la presentación de una petición de quiebra de mala fe con el único propósito de evitar un desalojo.

Consecuencias No Intencionadas

Las asociaciones de abogados publican resúmenes de casos disciplinarios. Cumplen una función importante al recordar a los abogados sus obligaciones profesionales, identificar conductas que caen por debajo de los estándares éticos y promover la educación y la disuasión. Sin embargo, el mensaje educativo debe reflejar con precisión la naturaleza de la mala conducta en cuestión.

Los jueces y los organismos sancionadores operan bajo un mandato diferente. Las sanciones deben ajustarse al caso, fundamentadas en la equidad y la proporcionalidad. Las decisiones disciplinarias requieren calibración y diferenciación, con resultados anclados en hallazgos específicos de intención, grado de culpabilidad y daño real o potencial.

El Camino a Seguir para las Sanciones Futuras

Es razonable esperar que este caso sea citado en futuros casos que involucren alucinaciones de IA. La profesión se encuentra en una encrucijada. Un camino trata las citas alucinadas principalmente como un problema de resultado, mientras que el otro las trata como un problema de culpabilidad. La sanción debe basarse en la conducta del abogado antes, durante y después del error.

Las sanciones para errores relacionados con IA deben depender de la culpabilidad, no solo del resultado. Esto permite a los tribunales y organismos disciplinarios responder firmemente donde se justifique, mientras se preserva la proporcionalidad y la equidad en casos que involucren errores aislados relacionados con IA.

Educación y Competencia

Cualquier discusión sobre sanciones por alucinaciones de IA sería incompleta sin reconocer un problema más profundo. La profesión legal todavía lucha con la educación sobre IA. Las instituciones deben asegurarse de que los profesionales legales comprendan cómo funcionan estas herramientas, cómo fallan y cómo utilizarlas de manera responsable.

La solución no son solo sanciones más severas, sino una mejor educación junto con expectativas claras. Evitar alucinaciones requiere entender los límites de los sistemas de IA, utilizarlos con un humano firmemente involucrado y verificar todas las citas y afirmaciones fácticas antes de presentarlas.

Conclusión

El aumento de alucinaciones generadas por IA en presentaciones judiciales presenta un desafío real y serio para la profesión legal. Los tribunales y las autoridades disciplinarias tienen razón al responder firmemente ante conductas que socavan la competencia y la integridad del proceso judicial. Las sanciones son una herramienta esencial para la disuasión y la corrección.

Pero la disciplina funciona mejor cuando está anclada en el contexto y la culpabilidad. Al entenderse correctamente, el caso refuerza ese principio. A medida que la IA generativa se integra en la práctica legal, la tarea de la profesión es doble: hacer cumplir las obligaciones éticas existentes con claridad y coherencia, y garantizar que los abogados y jueces estén equipados para cumplir con esas obligaciones a través de una educación y supervisión significativas.