Il Nuovo Modello di Governance per l’IA Agente a Singapore (2026)

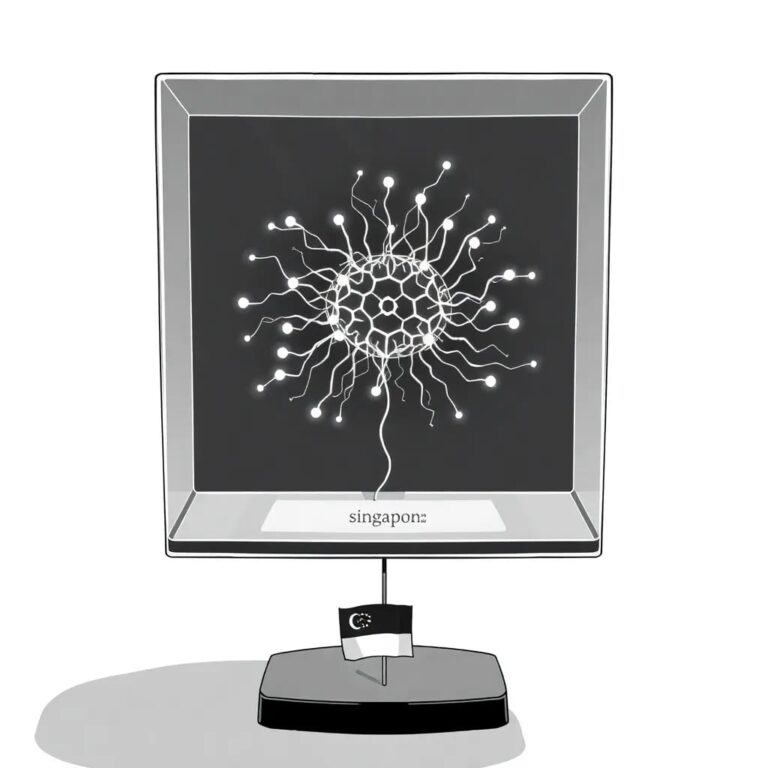

Questa pubblicazione introduce il primo quadro di governance completo al mondo per l’intelligenza artificiale (IA) agente, sistemi capaci di ragionamento, pianificazione e azione autonomi. Questo nuovo Modello di Governance per l’IA Agente rappresenta un’evoluzione significativa nella strategia di regolamentazione dell’IA, fornendo indicazioni su come gestire i rischi legati all’implementazione di tali sistemi.

Cos’è l’IA Agente?

L’IA agente ha la capacità di avviare compiti, aggiornare banche dati, eseguire azioni e adattarsi dinamicamente. Tuttavia, introduce nuovi rischi come azioni non autorizzate, perdita di dati e decisioni biased.

Pilastri Chiave della Governance

Il Modello di Governance per l’IA Agente si basa sui seguenti concetti chiave:

- Valutare e Limitare i Rischi Inizialmente: Le organizzazioni devono valutare i legami di sistema, la sensibilità dei dati, l’autonomia e gli effetti a cascata.

- Garantire una Responsabilità Umana Significativa: Il controllo umano deve rimanere centrale, con chiara allocazione delle responsabilità e punti di approvazione.

- Implementare Controlli Tecnici: I controlli includono sandboxing, test di sicurezza, monitoraggio e protezione contro abusi o escalation di privilegi.

- Promuovere la Responsabilità dell’Utente Finale: Formazione, trasparenza e la possibilità di intervenire o disattivare gli agenti sono essenziali.

Un Quadro Volontario ma Globalmente Influente

Pur non essendo vincolante, il quadro contribuisce a plasmare le norme globali e integra strumenti di governance esistenti.

Implicazioni per le Organizzazioni

Le organizzazioni dovrebbero perfezionare i modelli di supervisione, limitare i privilegi degli agenti, rafforzare il monitoraggio e prepararsi a un controllo normativo.

Prossimi Passi

Le entità devono partecipare a consultazioni, migliorare i test e rafforzare la documentazione per un’implementazione responsabile.