Il tuo AI aziendale è una minaccia nascosta? Svelare i pericoli dell’AI ombra

In questo momento, da qualche parte nella tua organizzazione, qualcuno si sta registrando per uno strumento di intelligenza artificiale (AI). Potrebbe essere un manager marketing che sperimenta la generazione di contenuti, oppure uno sviluppatore che integra un assistente alla programmazione AI. Potrebbe anche essere un team finanziario che esplora la reportistica automatizzata.

Non si stanno comportando in modo avventato, ma sono ingegnosi. Hanno trovato qualcosa che rende il loro lavoro più veloce, facile e migliore. Hanno collegato lo strumento ai tuoi sistemi, concesso accesso ai tuoi dati e sono andati avanti con la loro giornata.

Quello che probabilmente non hanno fatto è informare il team IT. E ciò che il team IT quasi certamente non ha fatto è integrare questo strumento e le sue identità associate nel tuo framework di governance. Questo è l’AI ombra. E sta creando una crisi di identità che la maggior parte delle organizzazioni non si rende ancora conto di avere.

La crescente adozione dell’AI

L’adozione dell’AI nelle imprese sudafricane è accelerata drammaticamente. Secondo un documento del World Economic Forum e del Global Cyber Security Capacity Centre dell’Università di Oxford, gran parte dell’attuale implementazione dell’AI è esplorativa o sperimentale, con le organizzazioni che utilizzano approcci basati su casi d’uso che enfatizzano l’ideazione e l’implementazione rapida.

Il problema non è l’esperimento in sé. L’innovazione richiede libertà di esplorare. Il problema è cosa succede dopo: gli esperimenti diventano parte integrante delle operazioni aziendali senza la rigorosa valutazione del rischio, il testing dei sistemi e la supervisione della governance che le implementazioni formali richiederebbero.

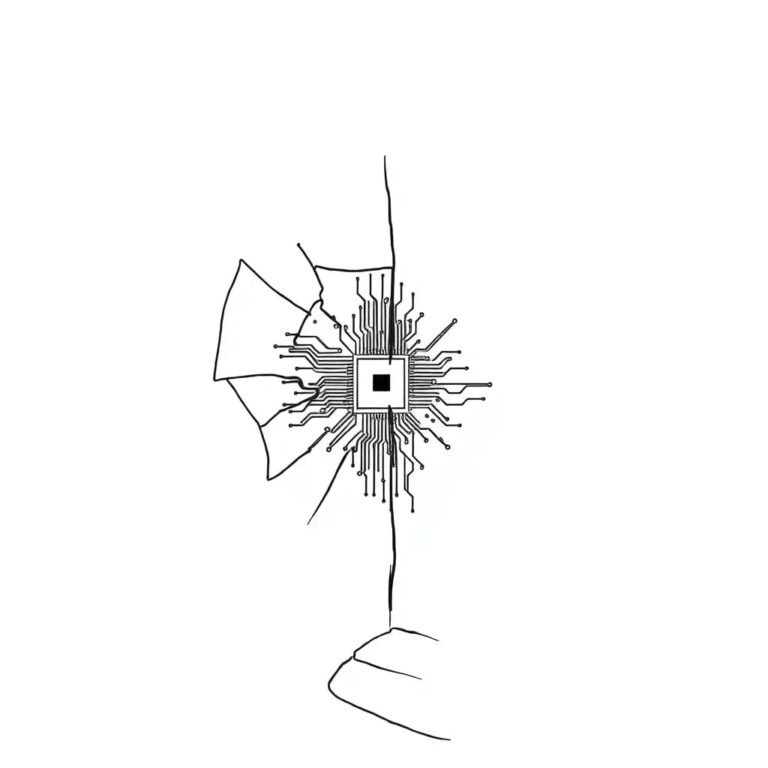

Identità non umane e AI ombra

Ogni strumento di AI che si connette al tuo ambiente crea nuove identità. Chiavi API che autenticano le richieste, account di servizio che accedono a database, token che mantengono connessioni persistenti. Queste identità non umane si moltiplicano rapidamente, spesso senza apparire in alcun registro o rientrare in alcuna politica di governance.

In organizzazioni dove le identità non umane già superano il numero degli utenti umani in un rapporto di 10:1 o più, l’AI ombra accelera ulteriormente questo squilibrio, completamente al di fuori della visibilità del tuo team di sicurezza.

La gestione tradizionale delle identità e degli accessi era progettata con un processo chiaro in mente. Qualcuno richiede accesso, la richiesta viene valutata, l’accesso è concesso o negato e la decisione è registrata. Quando le circostanze cambiano, l’accesso viene riesaminato e modificato.

L’AI ombra bypassa completamente questo processo. Non c’è richiesta perché nessuno pensa di farne una. Non c’è valutazione perché lo strumento sembra innocuo. Non c’è registrazione perché la connessione avviene al di fuori dei canali autorizzati. Quando l’impiegato che ha configurato lo strumento passa a un altro ruolo o lascia l’azienda, lo strumento AI e le sue identità rimangono — orfane, non monitorate e potenzialmente vulnerabili.

Rischi e implicazioni

La mancanza di programmi di rollout formali diminuisce la trasparenza, indebolendo i processi di gestione e la supervisione della leadership. La gestione software poco rigorosa amplifica il problema, poiché l’AI viene introdotta attraverso browser non autorizzati, plugin e strumenti open-source che gli sviluppatori adottano senza revisione.

Ciò che inizia con la produttività individuale diventa esposizione organizzativa. Ecco un test pratico. La tua organizzazione può rispondere a queste domande con fiducia?

Quanti strumenti di AI sono attualmente connessi ai tuoi sistemi? Quali di questi sono stati formalmente approvati e quali sono arrivati tramite adozione informale? A quali dati possono accedere questi strumenti? Quali identità sono state create per abilitare queste connessioni? Chi possiede queste identità? Quando sono state ruotate l’ultima volta le credenziali? Cosa succede a queste connessioni quando l’impiegato che le ha create se ne va?

Nel nostro lavoro con le imprese sudafricane, scopriamo che la maggior parte non può rispondere nemmeno a metà di queste domande. Il divario qui è legato all’infrastruttura. Gli strumenti e i processi progettati per gestire le identità della forza lavoro umana semplicemente non sono stati costruiti per la popolazione in espansione delle identità delle macchine che l’adozione dell’AI crea.

Strategie per affrontare l’AI ombra

Affrontare l’AI ombra richiede di partire da ciò che puoi controllare: la visibilità. Non puoi governare ciò che non puoi vedere, e non puoi vedere ciò che non stai cercando.

La scoperta è il primo passo essenziale. La scansione automatizzata identifica le integrazioni AI nel tuo ambiente, sia quelle autorizzate che quelle non autorizzate. Molti deployment di AI ombra esistono semplicemente perché non c’era un processo chiaro per l’adozione formale. Rendi quel processo visibile e accessibile riduce l’incentivo a eluderlo.

La creazione di un inventario segue la scoperta. Ogni strumento di AI, ogni identità associata, è mappata a un proprietario umano e a uno scopo aziendale. Questo crea responsabilità. Quando il nome di qualcuno è collegato a un’integrazione, la conversazione sulla governance diventa naturale piuttosto che avversariale.

La politica deve evolversi per adattarsi alla realtà. Linee guida complete che coprono come l’AI può essere utilizzata all’interno dell’organizzazione, come i nuovi strumenti vengono esaminati prima dell’implementazione e come le identità create da questi strumenti vengono gestite durante il loro ciclo di vita assicurano che l’innovazione non crei rischi indesiderati.

C’è anche un elemento umano. Gli impiegati adottano l’AI ombra perché ne vedono il valore. Bloccare completamente quell’adozione spinge il comportamento ulteriormente sottoterra. L’approccio più efficace combina l’abilitazione con la governance.

Ciò significa garantire che gli amministratori IT siano educati e sufficientemente qualificati per valutare e gestire gli strumenti di AI. Significa creare percorsi chiari per gli impiegati per richiedere nuovi strumenti, con tempi di risposta che non li spingano verso alternative non ufficiali. Significa riconoscere che l’adozione dell’AI è inevitabile e posizionare il tuo framework di identità per accoglierla piuttosto che resisterle.

Conclusione

Le organizzazioni che gestiscono correttamente questa situazione trattano l’AI ombra come un segnale, non solo come una minaccia. Comprendono dove e perché gli impiegati vogliono soluzioni AI. Questi approfondimenti possono informare un’adozione strategica dell’AI che offre i benefici in termini di produttività mantenendo la sicurezza e la governance.

L’AI ombra è una realtà attuale che diventa sempre più complessa con il passare delle settimane. Ogni nuovo strumento adottato senza supervisione, ogni chiave API creata senza governance, e ogni account di servizio che esiste al di fuori del tuo framework di identità accumulano rischi che diventano più difficili da affrontare più a lungo vengono ignorati.

La buona notizia è che i principi per gestire questa sfida esistono già. Scoperta, inventario, proprietà, gestione del ciclo di vita e monitoraggio continuo sono gli stessi fondamenti che si applicano a qualsiasi popolazione di identità. Ciò che è richiesto è estendere il loro raggio d’azione per comprendere gli strumenti di AI già operanti nel tuo ambiente.

L’AI che il tuo team ha adottato la scorsa settimana ha la sua identità. La domanda è se la gestirai in modo proattivo o la scoprirai durante un’indagine sugli incidenti.