Legge sulla Trasparenza nell’Intelligenza Artificiale della California: Un Passo Avanti

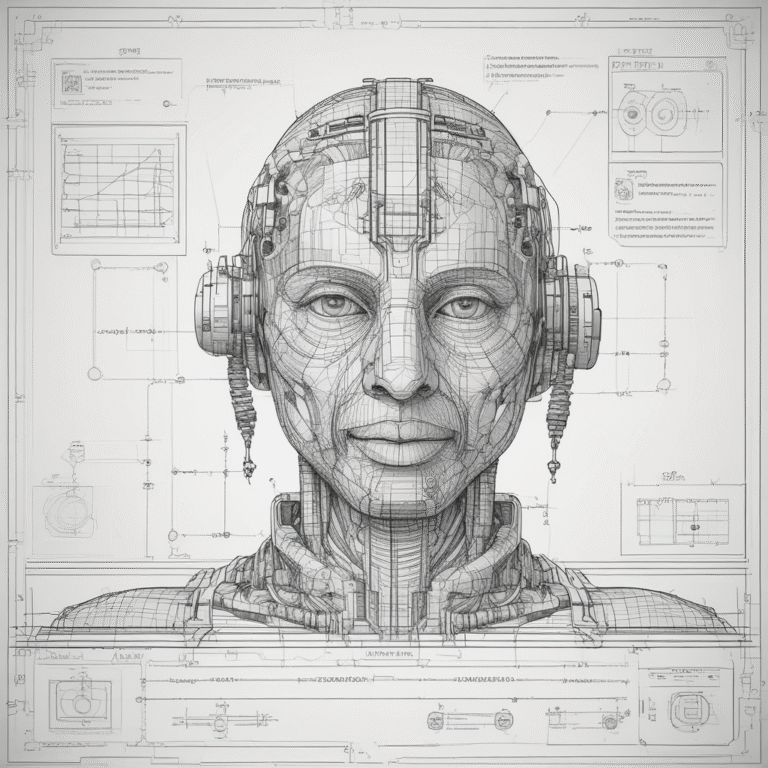

La California ha fatto notizia a livello globale approvando una legge storica sulla trasparenza nell’IA, focalizzata specificamente sui “modelli di frontiera” — i sistemi di intelligenza artificiale più capaci e potenzialmente influenti attualmente in sviluppo.

Questa legislazione, conosciuta come il Transparency in Frontier Artificial Intelligence Act (SB 53), è stata lodata come uno dei più forti quadri al mondo per garantire responsabilità, sicurezza e fiducia pubblica nel campo in rapida evoluzione dell’intelligenza artificiale.

Cosa Sono i “Modelli di Frontiera”?

I modelli di frontiera sono sistemi di intelligenza artificiale all’avanguardia, tipicamente reti neurali su larga scala, in grado di eseguire o generalizzare compiti a livello di esperti umani in vari domini. Questi modelli, spesso frutto di investimenti miliardari e cluster di supercalcolo, includono modelli linguistici generativi all’avanguardia, sistemi multi-modali e motori di ragionamento avanzati.

Caratteristiche chiave dei modelli di frontiera includono:

- Capacità senza precedenti nella generazione di testo, codice, immagini e video.

- Potenziale di automatizzare o accelerare compiti sia benefici (ricerca medica, istruzione) che rischiosi (cyber attacchi, disinformazione).

- Comportamenti complessi e difficili da prevedere che possono evolvere con la scalabilità.

- Centralità nelle ambiziose agende di innovazione del settore pubblico e privato.

Le Motivazioni per la Trasparenza

Con la California che ospita la Silicon Valley e più laboratori di IA di livello mondiale di qualsiasi altra regione, i responsabili politici statali hanno affrontato crescenti richieste di bilanciare le opportunità economiche dell’IA con i rischi senza precedenti della tecnologia.

Le principali motivazioni dietro SB 53 includono:

- Sicurezza Pubblica: Prevenire esiti catastrofici, come cyber attacchi abilitati dall’IA, minacce biologiche o manipolazione politica.

- Responsabilità: Garantire che i sviluppatori di IA più potenti rivelino le precauzioni di sicurezza e segnalino incidenti critici.

- Innovazione: Promuovere la ricerca aperta e la collaborazione pubblico-privato in un ambiente sicuro e regolamentato.

- Protezione dei Consumatori: Fornire alla società un certo grado di fiducia e supervisione mentre l’impatto sociale dell’IA cresce.

- Leadership Internazionale: Stabilire la California come un modello per una governance efficace dell’IA, controbilanciando le tendenze verso l’auto-regolamentazione dell’industria.

Principali Disposizioni della Legge sulla Trasparenza dell’IA della California

SB 53 si concentra su grandi organizzazioni di IA che sviluppano e distribuiscono modelli di IA di frontiera, con requisiti calibrati in base alla dimensione del fatturato e all’ambito di sviluppo.

| Requisito | Applicabilità | Dettagli Chiave |

|---|---|---|

| Quadro dell’IA di Frontiera | Sviluppatori con fatturato annuale > $500M | Devono pubblicare un framework di valutazione/report di sicurezza. |

| Rapporti di Trasparenza Pubblica | Tutti i “sviluppatori coperti” | Pubblicare documentazione annuale di mitigazione dei rischi. |

| Segnalazione di Incidenti Critici | Tutti i “sviluppatori coperti” | Segnalare eventi significativi di sicurezza IA entro 15 giorni. |

| Protezione per Whistleblower | Tutti i “sviluppatori coperti” | Garanzie per i dipendenti che segnalano violazioni. |

| Penali Civili per Non-Conformità | Tutti i “sviluppatori coperti” | Fino a $1M per violazione. |

Le aziende devono divulgare le loro metodologie — redatte per segreti commerciali — per la valutazione dei rischi, le misure di sicurezza e il monitoraggio dei modelli.

Implicazioni per gli Sviluppatori di IA e le Aziende Tecnologiche

Con la legge SB 53, i principali laboratori di IA devono istituire quadri formali per la valutazione dei rischi, la gestione degli incidenti e la documentazione della trasparenza. I consigli aziendali e i team di leadership sono responsabili della conformità, con potenziali sanzioni per la mancata divulgazione o risposta agli incidenti critici.

Considerazioni Finali

Con l’approvazione della Transparency in Frontier Artificial Intelligence Act, la California si posiziona all’avanguardia della governance responsabile dell’IA, inviando un messaggio chiaro che innovazione e sicurezza devono progredire insieme. Questa legge, centrata sulla trasparenza pubblica, sulla segnalazione degli incidenti e sulla supervisione indipendente, offre un modello su come le società democratiche possano sia sfruttare che contenere il potere della tecnologia trasformativa.