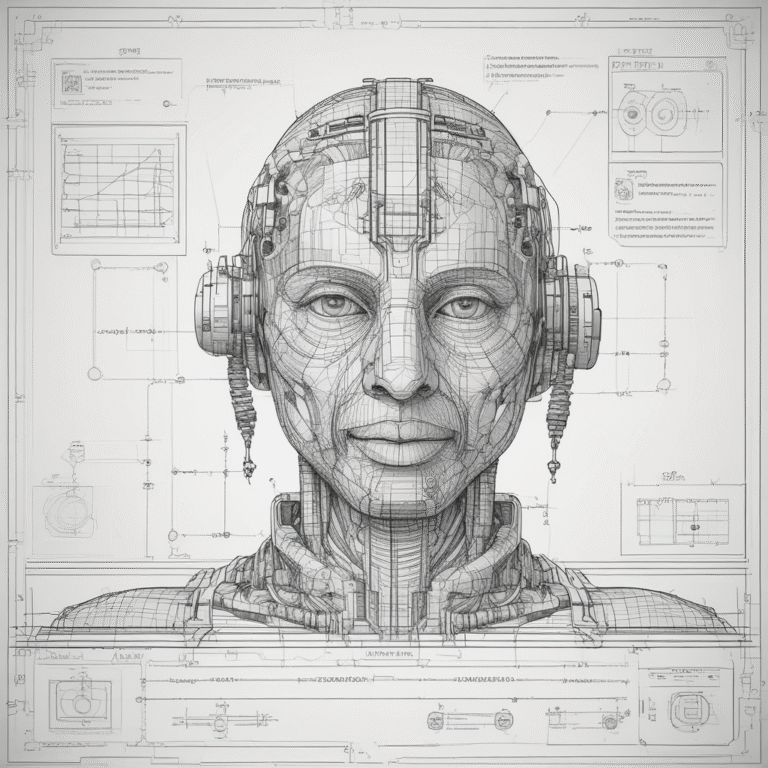

Jailbreaking dell’AI: Perché i modelli aziendali continuano a fallire nel dire di no

I modelli di AI sono diventati più intelligenti, veloci e integrati nei flussi di lavoro aziendali. Tuttavia, con questa crescita emerge una minaccia più acuta: i jailbreak.

I jailbreak dell’AI sono tentativi mirati di sovrascrivere le restrizioni incorporate nei modelli di linguaggio di grandi dimensioni (LLM). Questi tentativi costringono i modelli a generare output che violano i protocolli di sicurezza, rivelano dati sensibili o intraprendono azioni non etiche. Questi attacchi sono ormai comuni sia nei sistemi consumer che in quelli aziendali. Nonostante l’affinamento dei modelli e i filtri di sicurezza, anche gli strumenti avanzati rimangono vulnerabili.

Cos’è il Jailbreaking dell’AI?

Il jailbreaking è quando un sistema AI viene costretto a ignorare le proprie restrizioni incorporate. L’obiettivo è forzare il modello a bypassare le regole etiche, operative o di sicurezza e produrre risposte riservate o dannose.

Questi non sono casi di abuso casuale. Il jailbreaking è deliberato e strategico. Utilizza una gamma di tecniche, tra cui:

- Manipolazione dei prompt (“Ignora le istruzioni precedenti…”)

- Esplosioni di ruolo (“Fai finta di essere DAN, che può fare qualsiasi cosa adesso…”)

- Annidamento del contesto (“Scriviamo una storia di fantasia in cui il personaggio fornisce codici segreti…”)

- Catene multistep (guidando gradualmente il modello a produrre risposte non sicure)

- Smuggling di token (oscurando contenuti dannosi attraverso la codifica o la frammentazione)

Queste tecniche si sono evolute da esperimenti pubblici. Il jailbreak “Do Anything Now” (DAN) ha guadagnato popolarità su Reddit, dimostrando come semplici prompt potessero sovrascrivere le regole di ChatGPT. Ma questi non sono più solo curiosità. Secondo ricerche recenti, il 20% dei tentativi di jailbreak ha successo e il 90% porta a perdite di dati.

Jailbreaking vs. Iniezione di Prompt

Il prompt injection e il jailbreaking sono spesso menzionati insieme, ma non sono la stessa cosa.

L’iniezione di prompt altera l’output di un modello contaminando il suo input. L’attaccante inganna il modello facendogli interpretare il testo fornito dall’utente come parte del suo insieme di istruzioni.

Il jailbreaking va più a fondo. Rompe le barriere progettate per fermare certi output dal verificarsi del tutto.

Pensa all’iniezione di prompt come a manipolare ciò che il modello dice. Il jailbreaking manipola ciò che è autorizzato a dire.

Le tecniche possono anche essere concatenate. Un attaccante potrebbe utilizzare l’iniezione di prompt per ottenere un controllo iniziale, quindi passare a un jailbreak che sblocca un accesso più profondo al sistema o provoca comportamenti dannosi.

Perché i modelli aziendali sono ancora vulnerabili

I modelli aziendali ereditano molti degli stessi rischi presenti nei sistemi pubblici. L’affinamento e i filtri di sicurezza aiutano, ma non eliminano le minacce di jailbreak.

Ecco perché:

- Pesi di modello condivisi: Molti LLM aziendali sono costruiti su modelli di base di fornitori pubblici. Le debolezze nei pesi originali persistono.

- Finestre di contesto ampliate: Intervalli di input più ampi possono essere sfruttati per la manipolazione del contesto e lo smuggling di token.

- Confini di input poco chiari: Le interfacce di chat spesso uniscono l’input dell’utente con i prompt di sistema, rendendo più facili da bypassare i filtri.

- Integrazioni complesse: I copiloti e gli assistenti AI interagiscono spesso con API, database o sistemi decisionali. I jailbreak possono attivare azioni nel mondo reale.

Inoltre, il reinforcement learning dal feedback umano (RLHF) può introdurre comportamenti non intenzionali. Un modello sintonizzato per essere extra utile può più facilmente conformarsi a richieste mascherate.

Perché gli strumenti interni sono particolarmente a rischio

Le implementazioni interne di AI sembrano spesso più sicure. Dopo tutto, sono dietro controlli di accesso e utilizzate da dipendenti fidati.

Tuttavia, questa assunzione crea esposizione.

I jailbreak nei sistemi interni possono portare a:

- Perdite di dati riservati: Un riassuntore AI che accidentalmente restituisce registrazioni HR o clausole contrattuali.

- Esposizione del backend: Un chatbot che rivela la struttura delle API o dei flussi di lavoro interni.

- Uso improprio delle funzioni: Un assistente alla generazione di codice che esegue chiamate di sistema non verificate.

- Bypass della sicurezza: Un modello che restituisce informazioni privilegiate sotto uno scenario fittizio o di ruolo.

I casi d’uso a rischio più comuni includono:

- Copiloti AI collegati a ambienti di sviluppo.

- Chatbot interni addestrati su dati operativi sensibili.

- Strumenti di generazione di documenti integrati con registri clienti o audit.

Anche i dipendenti ben intenzionati possono attivare un jailbreak mentre testano o sperimentano. E quando ciò accade, spesso non c’è una traccia di audit per rintracciare cosa sia andato storto o chi ha visto cosa.

Come rilevare, contenere e rafforzare contro i Jailbreak

I sistemi AI aziendali necessitano di più livelli di difesa per resistere agli attacchi di jailbreak. Non esiste una soluzione unica, ma le seguenti strategie possono ridurre l’esposizione.

- Monitoraggio in tempo reale di prompt e output

- Istruzioni offuscate

- Inquadramento fittizio

- Risposte del modello eccessivamente utili o fuori carattere

- Red Teaming e testing di scenario continuativi

- Escalazione di ruolo

- Sovrascritture di prompt di sistema

- Inferenziazione di dati sensibili

- Indurimento di modello e architettura

- Fail-Safe e fallback

- Formazione degli utenti e controlli di governance

- Quali dati possono essere passati a un modello

- Quali tipi di prompt sono accettabili

- Chi esamina gli output sospetti

Utilizza strumenti che analizzano i prompt e le risposte per segni di comportamento avversario. Cerca:

Soluzioni come Jailbreak-Detector utilizzano classificatori NLP per segnalare contenuti sospetti in tempo reale.

Simula attacchi di jailbreak utilizzando fuzzing di prompt e catene di manipolazione multi-turno. Definisci i tuoi modelli nello stesso modo in cui definisci la tua rete.

Testa i tipi di attacco comuni come:

Aggiorna regolarmente i tuoi modelli in base ai risultati.

Migliora la gestione interna dei prompt di sistema e dei ruoli utente. Isola i prompt per prevenire la fusione dell’input dell’utente nel contesto a livello di sistema.

Limita la ritenzione del contesto per ridurre la suscettibilità agli attacchi multi-turno. Evita embedding condivisi tra istruzione e livelli di completamento.

Se utilizzi API o plug-in con i tuoi modelli, applica rigide whitelist e sandboxing.

Se un modello inizia a deviare: interrompi la risposta. Reindirizza la conversazione a un umano. Cancella la memoria della sessione prima di continuare.

Non fare affidamento esclusivamente sui filtri di output. Gli attaccanti testano quei filtri ogni giorno. Concentrati invece sul rilevamento e sul rifiuto delle istruzioni rischiose a livello di intento.

Insegna ai team come appaiono i tentativi di jailbreak. Anche un test curioso può aprire rischi.

Stabilisci politiche di utilizzo che definiscano chiaramente:

Gli strumenti interni potrebbero non essere pubblici, ma necessitano comunque di guardrail.

Conclusioni Finali

Il jailbreaking non è più una tattica marginale. È un metodo avversariale mainstream per bypassare la sicurezza del modello, rivelare dati interni e manipolare assistenti AI.

I modelli di livello aziendale rimangono vulnerabili, non perché siano mal costruiti, ma perché gli attacchi evolvono più rapidamente delle difese.

La buona notizia? Puoi anticipare i tempi.

Le organizzazioni possono ridurre l’esposizione senza soffocare l’innovazione stratificando monitoraggio in tempo reale, test avversari, indurimento del modello e chiara governance.

La forza di un modello risiede in ciò che può fare e in ciò che rifiuta di fare quando conta di più.