AI, A2A und die Governance-Lücke

In den letzten sechs Monaten wurde ein wiederkehrendes Muster in den KI-Teams von Unternehmen beobachtet. A2A und ACP beeindrucken während der Architekturüberprüfungen – die Protokolle sind elegant, die Demos beeindruckend. Drei Wochen nach der Inbetriebnahme fragt jemand: „Warte, welcher Agent hat die Zahlung von 50.000 $ an den Anbieter um 2 Uhr morgens autorisiert?“ Die Aufregung weicht der Besorgnis.

Hier ist das Paradoxon: Agent2Agent (A2A) und das Agent Communication Protocol (ACP) sind so effektiv darin, Integrationsfriktionen zu beseitigen, dass sie die natürlichen „Bremsen“ entfernt haben, die früher Governance-Gespräche erzwungen haben. Das Problem der Integration wurde brillant gelöst, jedoch wurde eine neue Art von Integrationsschulden geschaffen – eine, bei der Organisationen heute Geschwindigkeit auf Kosten von Verantwortlichkeit morgen „ausleihen“.

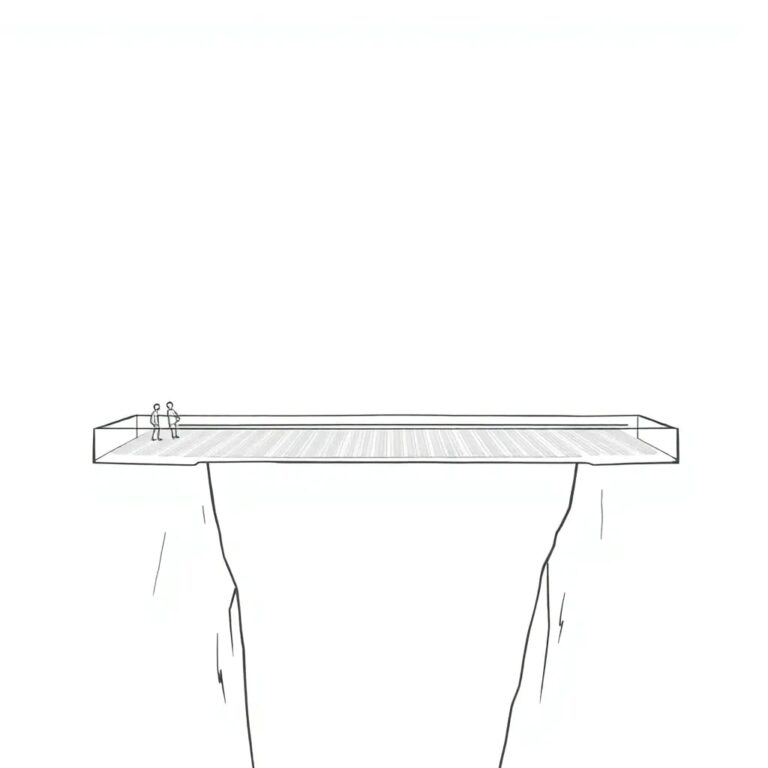

Die technischen Protokolle sind solide. Die organisatorischen Protokolle fehlen. Wir bewegen uns schnell von der Phase „Können diese Systeme verbunden werden?“ zur Phase „Wer hat diesen Agenten autorisiert, eine Position um 3 Uhr morgens zu liquidieren?“ In der Praxis schafft dies eine Governance-Lücke: Unsere Fähigkeit, Agenten zu verbinden, übertrifft unsere Fähigkeit, zu kontrollieren, wozu sie uns verpflichten.

Entwicklung des Agentenstapels

Um zu verstehen, warum dieser Wandel so schnell geschieht, ist es hilfreich, sich anzusehen, wie sich der zugrunde liegende „Agentenstapel“ entwickelt. Wir sehen das Entstehen einer dreistufigen Struktur, die die traditionelle API-gesteuerte Konnektivität leise ersetzt:

- Schicht: Tooling

Protokollbeispiele: MCP (Model Context Protocol)

Zweck: Verbindet Agenten mit lokalen Daten und spezifischen Tools

Der „menschliche“ Analog: Werkzeugkasten eines Arbeitnehmers - Schicht: Kontext

Protokollbeispiele: ACP (Agent Communication Protocol)

Zweck: Standardisiert, wie Ziele, Benutzerhistorie und Status zwischen Agenten übertragen werden

Der „menschliche“ Analog: Gedächtnis und Briefing eines Arbeitnehmers - Schicht: Koordination

Protokollbeispiele: A2A (Agent2Agent)

Zweck: Behandelt Entdeckung, Verhandlung und Delegation über Grenzen hinweg

Der „menschliche“ Analog: Ein Vertrag oder Handschlag

Dieser Stapel macht Multi-Agenten-Workflows zu einem Konfigurationsproblem anstatt zu einem maßgeschneiderten Ingenieureingriff. Genau das ist der Grund, warum die Risikofläche schneller wächst, als die meisten Sicherheitsverantwortlichen realisieren.

Agentenprotokolle reduzieren nicht die Komplexität; sie umgehen sie. In der API-Ära reichten Menschen Tickets ein, um Systemaktionen auszulösen. In der A2A-Ära verwenden Agenten „Agentenkarten“, um einander zu entdecken und auf diesen Systemen zu verhandeln. ACP ermöglicht es diesen Agenten, reichhaltigen Kontext auszutauschen – das bedeutet, dass ein Gespräch im Kundenservice nahtlos in die Erfüllung und Partnerlogistik übergehen kann, ohne menschliche Übergaben. Was früher API-Überlastung war, wird zu Dutzenden von semi-autonomen Prozessen, die im Namen Ihres Unternehmens über Infrastrukturen handeln, die Sie nicht vollständig kontrollieren. Die Reibung der manuellen Integration diente früher als natürliche Bremse für Risiken; A2A hat diese Bremse entfernt.

Governance-Lücke und Risikoimplikationen

Diese Governance-Lücke zeigt sich nicht als ein einzelner katastrophaler Fehler. Sie zeigt sich als eine Reihe kleiner, verwirrender Vorfälle, bei denen alles in den Dashboards „grün“ aussieht, aber das Geschäftsergebnis falsch ist. Die Protokolldokumentation konzentriert sich auf Verschlüsselung und Handschläge, ignoriert jedoch die aufkommenden Fehlermodi der autonomen Zusammenarbeit. Diese sind keine Bugs in den Protokollen; sie sind Anzeichen dafür, dass die umgebende Architektur nicht mit dem Niveau der Autonomie Schritt gehalten hat, das die Protokolle ermöglichen.

Politikdrift: Eine Rückerstattungsrichtlinie, die in einem Service-Agenten kodiert ist, kann technisch mit dem Inkasso-Agenten eines Partners über A2A interagieren, aber ihre Geschäftslogik kann diametral entgegengesetzt sein. Wenn etwas schiefgeht, besitzt niemand das End-to-End-Verhalten.

Kontextüberschreitung: Ein Team könnte ein ACP-Schema erweitern, um „Benutzersentiment“ für eine bessere Personalisierung einzuschließen, ohne zu wissen, dass diese Daten nun an jeden nachgelagerten Drittanbieter-Agenten in der Kette weitergegeben werden. Was als lokale Anreicherung begann, wird zur verteilten Exposition.

Der Determinismus-Falle: Im Gegensatz zu REST-APIs sind Agenten nicht deterministisch. Die Logik der Rückerstattungsrichtlinie eines Agenten könnte sich ändern, wenn sein zugrunde liegendes Modell von GPT-4 auf GPT-4.5 aktualisiert wird, obwohl die A2A-Agentenkarte identische Fähigkeiten erklärt. Der Workflow „funktioniert“ – bis er es nicht mehr tut, und es gibt keine Versionsverfolgung zur Fehlersuche. Dies schafft das, was als „Gespensterfehler“ bezeichnet wird: Fehler, die in traditionellen Beobachtungen nicht angezeigt werden, weil der Schnittstellenvertrag unverändert aussieht.

Notwendigkeit einer Governance-Strategie

Diese Fehlermodi haben eine gemeinsame Ursache: Die technische Fähigkeit zur Zusammenarbeit zwischen Agenten hat die Fähigkeit der Organisation überholt, zu bestimmen, wo diese Zusammenarbeit angemessen ist und unter welchen Einschränkungen.

Deshalb benötigen wir etwas über den Protokollen selbst: eine explizite „Agentenvertrag“-Schicht. Wenn das Protokoll die Sprache ist, ist der Vertrag die Verfassung. Governance muss von „Nebendokumentation“ zu „Politik als Code“ übergehen.

Traditionelle Governance behandelt Politikverletzungen als Mängel, die es zu verhindern gilt. Ein antifragiler Ansatz betrachtet sie als Signale, die es zu nutzen gilt. Wenn ein Agent eine Verpflichtung eingeht, die eine Geschäftsgrenze verletzt, sollte das System dieses Ereignis erfassen, die Ursache zurückverfolgen und in das Training des Agenten sowie in die Vertragsregelungen zurückspeisen. Im Laufe der Zeit wird die Governance-Schicht intelligenter, nicht nur strenger.

Vertragsniveau-Einschränkungen definieren: Autorisieren Sie nicht nur eine Verbindung; autorisieren Sie einen Umfang. Welche ACP-Felder darf ein Agent teilen? Welche A2A-Operationen sind „nur lesen“ gegenüber „rechtlich bindend“? Welche Kategorien von Entscheidungen erfordern eine menschliche Eskalation?

Verhalten versionieren, nicht nur das Schema: Behandeln Sie Agentenkarten als erstklassige Produktoberflächen. Wenn sich das zugrunde liegende Modell ändert, muss die Version erhöht werden, was eine Neubewertung des Vertrags auslöst. Dies ist keine bürokratische Belastung – es ist der einzige Weg, um Verantwortung in einem System aufrechtzuerhalten, in dem autonome Agenten im Namen Ihrer Organisation Verpflichtungen eingehen.

Übergreifende Rückverfolgbarkeit: Wir benötigen Beobachtbarkeitsspuren, die nicht nur Latenz anzeigen, sondern auch Absicht: Welcher Agent hat dieses Engagement eingegangen, unter welcher Politik? Und wer ist der menschliche Eigentümer? Dies ist besonders wichtig, wenn Workflows über organisatorische Grenzen und Partner-Ökosysteme hinweg gehen.

Fazit

Die Gestaltung dieser Vertragsschicht ist nicht nur ein Problem der Werkzeugbereitstellung. Es verändert, wer im Raum sein muss und wie sie über das System denken. Die größte Einschränkung ist nicht der Code; es sind die Menschen. Wir betreten eine Welt, in der Ingenieure über Multi-Agenten-Spieltheorie und Politikinteraktionen nachdenken müssen, nicht nur über SDK-Integration. Risikoteams müssen „Maschine-zu-Maschine-Verpflichtungen“ prüfen, die möglicherweise niemals in menschlicher Sprache dargestellt werden. Produktmanager müssen Agenten-Ökosysteme besitzen, in denen eine Änderung der Belohnungsfunktion oder des Kontextschemas eines Agenten das Verhalten in einem gesamten Partnernetzwerk beeinflusst. Compliance- und Prüfungsfunktionen benötigen neue Werkzeuge und Denkmodelle, um autonome Workflows zu überprüfen, die mit Maschinen-Geschwindigkeit ausgeführt werden. In vielen Organisationen liegen diese Fähigkeiten in unterschiedlichen Silos, und die Einführung von A2A/ACP erfolgt schneller als die erforderlichen funktionsübergreifenden Strukturen, um sie zu verwalten.

Die nächsten 18 Monate werden entscheidend dafür sein, ob Unternehmen einen Schritt voraus sind oder ob wir eine Welle von hochkarätigen Misserfolgen erleben, die eine nachträgliche Governance erzwingen. Das Risiko besteht nicht darin, dass A2A und ACP unsicher sind; es ist, dass sie zu effektiv sind. Für Teams, die diese Protokolle testen, sollte der Fokus nicht auf dem „glücklichen Weg“ der Konnektivität liegen. Stattdessen sollten sie einen Multi-Agenten-Workflow auswählen und ihn als kritisches Produkt instrumentieren.

Wenn dies gelingt, haben Sie ein wiederholbares Muster für die Skalierung von Agenteneinsätzen, ohne die Verantwortlichkeit zu opfern. Wenn es fehlschlägt, haben Sie etwas Kritisches über Ihre Architektur gelernt, bevor es in der Produktion zu einem Ausfall kommt. Wenn Sie einen Workflow so steuern, beobachten und lernen können, haben Sie eine Vorlage für den Rest Ihres Agenten-Ökosystems.

Wenn das letzte Jahrzehnt darin bestand, APIs als Produkte zu behandeln, wird das nächste darin bestehen, autonome Workflows als in den Verkehr zwischen Agenten kodierte Politiken zu behandeln. Die Protokolle sind bereit. Ihre Organisationsstruktur ist es nicht. Die Brücke zwischen beiden ist der Agentenvertrag – beginnen Sie, ihn zu bauen, bevor Ihre Agenten anfangen, Verträge ohne Sie zu unterzeichnen.