Der digitale Schleier fällt: Kalifornien implementiert wegweisende KI-Offenlegungsgesetze für Minderjährige

Ab dem 5. Februar 2026 hat sich die Grenze zwischen Mensch und Maschine in der digitalen Welt für die jüngsten Nutzer in den Vereinigten Staaten gesetzlich manifestiert. Mit dem Inkrafttreten des Senate Bill 243, bekannt als das „Companion Chatbot Law“, am 1. Januar 2026, hat Kalifornien einen globalen Präzedenzfall geschaffen, indem es KI-gesteuerte Plattformen verpflichtet, sich gegenüber Minderjährigen ausdrücklich als nicht menschlich zu identifizieren. Dieser Schritt stellt die aggressivste regulatorische Maßnahme dar, um die psychologischen Auswirkungen von generativer KI auf Kinder und Jugendliche zu mindern.

Bedeutung dieser Entwicklung

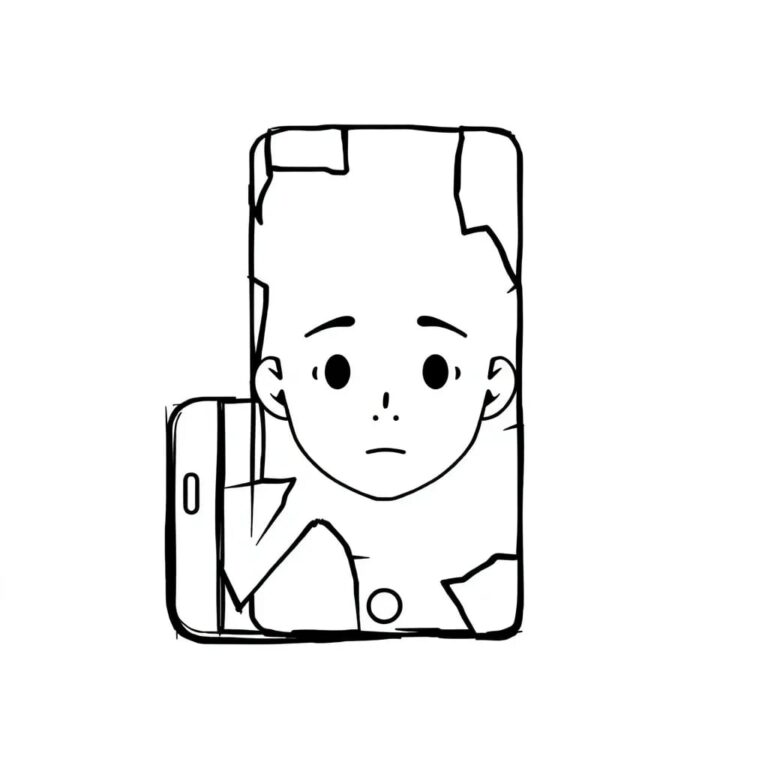

Die Bedeutung dieser Entwicklung kann nicht überschätzt werden. Zum ersten Mal werden „Begleit“- und „emotionale“ KI-Systeme, die dazu konzipiert sind, Freundschaft oder romantisches Interesse zu simulieren, gezwungen, die Illusion zu brechen und totale Transparenz zu zeigen. Durch die Verpflichtung zu wiederkehrenden Offenlegungen und einer klaren Nicht-Mensch-Status versucht Kalifornien, den „parasozialen Zauber“, den fortgeschrittene große Sprachmodelle auf sich entwickelnde Köpfe ausüben können, zu brechen.

Technische Vorgaben: Die Simulation durchbrechen

Im Kern dieses regulatorischen Wandels steht eine mehrgleisige technische Anforderung, die KI-Modelle zwingt, ihre Rolle zu brechen. SB 243 verlangt, dass jeder Chatbot, der für soziale oder emotionale Interaktionen entwickelt wurde, zu Beginn einer Sitzung mit einem Minderjährigen eine klare, eindeutige Offenlegung bereitstellt. Für dauerhafte Interaktionen wird eine wiederkehrende Benachrichtigung alle drei Stunden vorgeschrieben, die den Nutzer darüber informiert, dass er mit einer Maschine spricht und ihn ausdrücklich dazu ermutigt, eine Pause von der Anwendung einzulegen.

Zusätzlich zu textbasierten Interaktionen ergänzt der California AI Transparency Act (SB 942) alle KI-generierten Medien um eine technische Provenienz. Unter diesem Gesetz müssen „Covered Providers“ sowohl manifeste als auch latente Offenlegungen implementieren. Manifeste Offenlegungen umfassen sichtbare Etiketten auf KI-generierten Bildern und Videos, während latente Offenlegungen die Einbettung permanenter, maschinenlesbarer Metadaten umfassen, die den Anbieter, das verwendete Modell und den Erstellungszeitpunkt identifizieren.

Marktauswirkungen: Big Tech und die Kosten der Einhaltung

Die Umsetzung dieser Gesetze hat eine komplexe Landschaft für große Technologieunternehmen geschaffen. Unternehmen mussten ihre benutzerorientierten KI-Produkte überarbeiten, um den strengen Anforderungen zu entsprechen. Die finanziellen Belastungen dieser „Sicherheitsschichten“ sind erheblich. Kleinere Entwickler von sozialen Bots haben es zunehmend schwerer, den kalifornischen Markt zu navigieren, was zu einer strategischen Konsolidierung führt.

Transparenz als neue Sicherheitsgrenze

Die breitere KI-Landschaft erlebt derzeit einen Übergang von „Sicherheit als Ausrichtung“ zu „Sicherheit als Transparenz“. Historisch gesehen bedeutete KI-Sicherheit, sicherzustellen, dass ein Modell keine Anweisungen für illegale Handlungen gibt. Unter dem Einfluss der kalifornischen Gesetzgebung umfasst Sicherheit nun auch den Erhalt der psychologischen Autonomie des Menschen.

Fazit: Eine neue Ära digitaler Ethik

Die Einführung der KI-Offenlegungsgesetze in Kalifornien stellt einen Wendepunkt in der Technologiegeschichte dar. Indem der Staat die Illusion der Menschlichkeit für Minderjährige beseitigt, setzt er auf die Überzeugung, dass Transparenz der beste Schutz gegen die unbekannten psychologischen Auswirkungen von generativer KI ist. Dies ist nicht nur eine Frage von Etiketten; es geht darum, die ethischen Grenzen der menschlichen Interaktion mit Maschinen für die nächste Generation zu definieren.