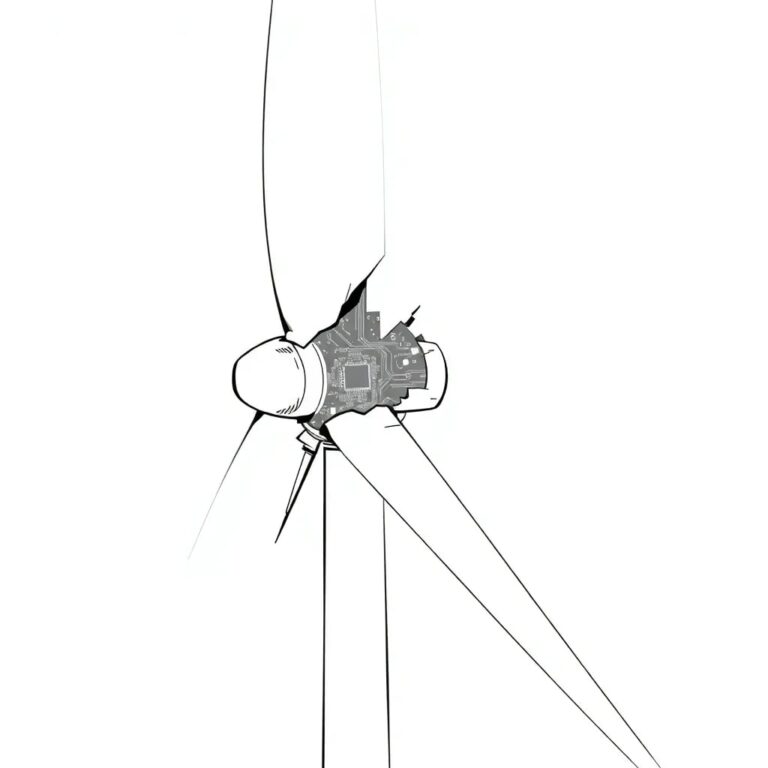

Alerte sur les lacunes de sécurité de l’IA exposant l’infrastructure énergétique aux attaques d’États-nations

De nouvelles recherches ont identifié plusieurs risques émergents dans le secteur de l’énergie et des services publics cette année. Les résultats indiquent que les lacunes dans les tests de sécurité des systèmes opérationnels face aux menaces d’États-nations, ainsi qu’un suivi centralisé faible permettant aux attaques de persister sans détection, posent des problèmes majeurs. Les organisations font également face à des délais de réponse prolongés en raison de l’absence de manuels de réponse spécifiques à l’IA, tandis qu’un faible engagement au niveau du conseil retarde les investissements nécessaires en sécurité. De plus, des lacunes de cryptage dans les données d’entraînement de l’IA exposent des informations opérationnelles sensibles.

Analyse des lacunes de sécurité

La recherche souligne que la gouvernance précoce de l’IA reste insuffisante dans le secteur. Seules 9 % des organisations énergétiques signalent avoir réalisé des tests de sécurité de type red-teaming, tandis que seulement 14 % maintiennent des manuels de réponse aux incidents spécifiques à l’IA, laissant des systèmes critiques vulnérables à des adversaires de plus en plus sophistiqués.

Pour 2026, il est prévu que des acteurs d’États-nations exploitent ces lacunes pour compromettre l’IA des infrastructures critiques. Le manque de surveillance centralisée laissera les attaques d’IA non détectées jusqu’à ce qu’un impact physique se produise, et les lacunes de réponse aux incidents prolongeront les temps de présence de la compromission d’IA.

Implications et risques

L’écart de red-teaming représente la vulnérabilité la plus dangereuse pour le secteur. Avec seulement 9 % d’implémentation, le secteur est à la traîne par rapport à la moyenne mondiale, et cela représente une invitation pour des adversaires sophistiqués. Les attaques potentielles incluent des attaques par injection sur l’IA de gestion de réseau, des entrées adversariales dans les systèmes de surveillance des pipelines, et du poisonnage de modèles dans la maintenance prédictive.

Les organisations doivent établir des programmes de red-teaming pour l’IA de manière urgente, en se concentrant particulièrement sur les systèmes d’IA interagissant avec la technologie opérationnelle. Cela inclut le test pour les injections d’instructions, les entrées adversariales, le poisonnage de modèles, et l’extraction de données. Cela doit être considéré comme une priorité de sécurité nationale.

Recommandations stratégiques

Les organisations doivent également déployer une surveillance centralisée de l’IA à travers l’infrastructure distribuée. Cela nécessite une visibilité centralisée sur les systèmes d’IA fonctionnant dans la gestion de réseau, les opérations de pipeline et les environnements de maintenance. Les architectures de surveillance doivent corréler les signaux entre ces systèmes, car les contrôles ponctuels au niveau des actifs individuels sont insuffisants.

Il est également urgent de développer des capacités de réponse aux incidents spécifiques à l’IA. Cela comprend la documentation des procédures de réponse pour les menaces telles que le poisonnage de modèles et la manipulation adversariale.

Conclusion

Enfin, les organisations doivent mettre en œuvre une protection des données en profondeur pour les données d’entraînement de l’IA, en veillant à ce que toutes les données contenant des informations sur les opérations des réseaux soient cryptées. Les principes de défense en profondeur doivent être appliqués, avec des contrôles d’accès limitant l’utilisation non autorisée et le cryptage protégeant les données en cas de défaillance de ces contrôles.