Risques sans frontières : l’utilisation malveillante de l’IA et la portée mondiale de la Loi sur l’IA de l’UE

Messages clés

La Loi sur l’Intelligence Artificielle (IA) de l’UE est l’une des premières réglementations contraignantes sur l’IA au monde. Les décideurs politiques de l’UE l’ont conçue comme un modèle pour la gouvernance mondiale de l’IA, en s’appuyant sur l’effet Bruxelles.

Dans un domaine en évolution rapide comme l’IA, la qualité de la réglementation est une condition préalable à son influence en tant que modèle. Cette qualité inclut la couverture adéquate des risques les plus critiques associés à l’utilisation, au déploiement et à l’adoption de l’IA.

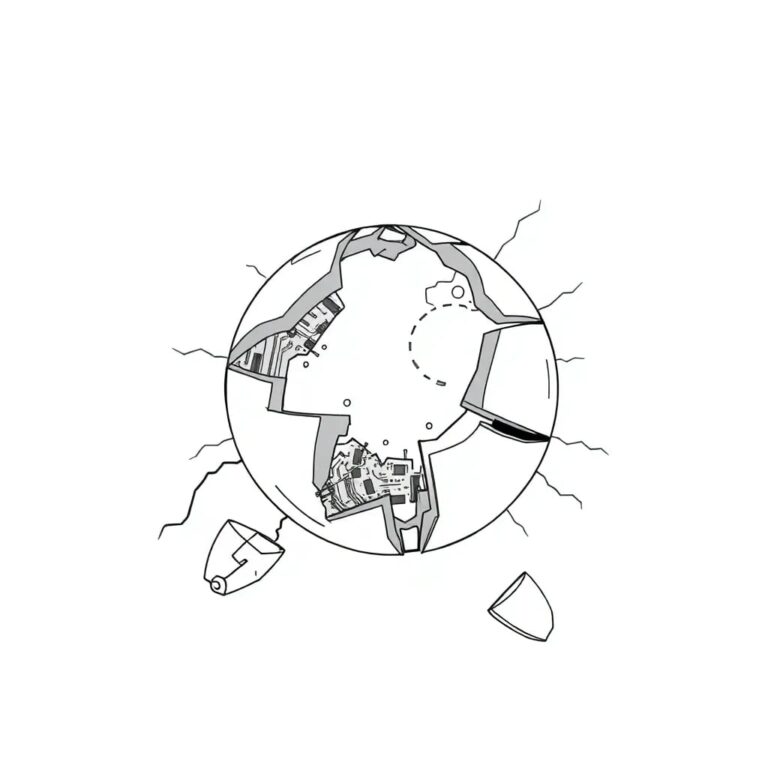

Parmi ces risques figure l’utilisation malveillante, qui résulte de l’utilisation intentionnelle des capacités de l’IA pour causer des dommages. Cette analyse teste les dispositions de la Loi sur l’IA face aux risques d’utilisation malveillante.

Analyse des efforts de sécurité de l’IA face aux pressions concurrentielles

Dans le paysage géopolitique actuel, la course à la domination de l’IA parmi les États et les entreprises se concentre sur le leadership technologique et les capacités, et non sur la sécurité et la gestion des risques.

La Loi sur l’IA de l’UE se distingue comme l’une des premières réglementations contraignantes au monde. Alors que d’autres gouvernements ont émis des documents sur la sécurité de l’IA, ceux-ci restent des principes larges et non contraignants, avec des mécanismes d’application ou de suivi faibles.

Couverture inégale des risques d’utilisation malveillante

La couverture des sous-risques d’utilisation malveillante par la Loi sur l’IA est inégale. Alors que certains sous-risques sont abordés directement, d’autres ne le sont qu’indirectement ou restent en dehors du champ d’application de la Loi.

Quatre sous-risques sont presque non réglementés, dont les menaces biologiques et chimiques, les IA intentionnelles, les armes autonomes et la concentration de pouvoir.

Quatre autres sous-risques sont seulement partiellement abordés, tels que la désinformation, le contenu abusif, la fraude et l’ingénierie sociale, ainsi que l’offensive cybernétique.

Conclusions

La Loi sur l’IA a suscité beaucoup d’attention au cours des dernières années. Cependant, peu d’attention a été accordée à l’adéquation de la couverture des risques de la Loi et à sa capacité à protéger la société contre les utilisations malveillantes de l’IA.

L’analyse révèle que la couverture des risques d’utilisation malveillante est inégale. Bien que les risques de surveillance d’État soient largement pris en compte, d’autres risques critiques restent largement inaddressés.

Pour que la Loi sur l’IA réussisse en tant que modèle de gestion des risques, il est nécessaire d’examiner et d’adapter ses dispositions afin de combler les lacunes identifiées.