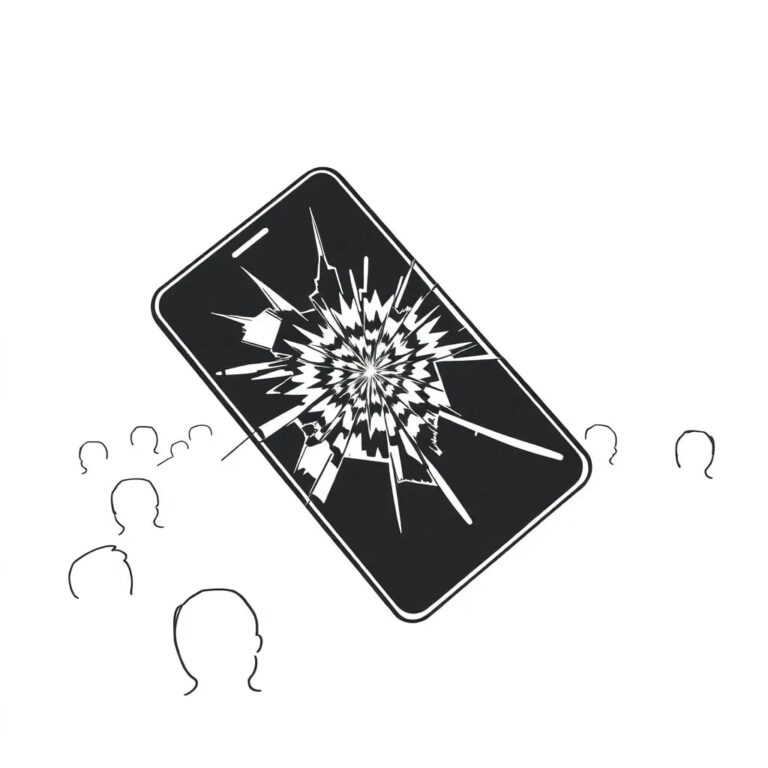

Comment l’IA agentique pourrait détruire les médias sociaux : la nécessité d’une gouvernance proactive

J’ai déjà vu cela auparavant. En 2000, j’ai construit un chatbot capable de communiquer avec d’autres bots à travers des réseaux. Nous l’appelions un « botnet » lorsque de nombreux bots exécutaient des actions coordonnées sur un ou plusieurs réseaux. Imaginez un message dans une salle de chat déclenchant une réponse dans une autre salle ou même sur un serveur différent, bien avant l’existence des API ou des outils d’automatisation tels que Hootsuite ou Zapier. Vous définissiez une règle concernant une commande, un déclencheur d’événement, une réponse automatique si un certain type de message était reçu, et le système agissait.

Vingt-cinq ans plus tard, l’IA agentique repose sur le même principe, mais à l’échelle du cloud. Les systèmes surveillent maintenant les événements, prennent des décisions et agissent avec peu de supervision humaine. Si nous ne gouvernons pas correctement cette couche, nous risquons de transformer l’Internet public en un circuit fermé de machines parlant à des machines.

Du texte à l’action

Là où l’IA générative écrit, l’IA agentique exécute. Elle peut rédiger, publier, répondre, acheter, planifier et optimiser sans attendre d’approbation. Une enquête de McKinsey en 2025 a révélé que la moitié des entreprises testaient déjà des flux de travail autonomes. Mais la gouvernance est à la traîne par rapport à l’adoption. Une étude mondiale de KPMG sur la confiance dans l’IA a montré que près des trois quarts des personnes ne savent pas quel contenu en ligne est authentique. L’illusion d’engagement constitue une menace pour la véritable communication.

Nous dérivons vers une situation absurde que très peu d’organisations semblent envisager. Un agent IA peut générer un post sur les médias sociaux. D’autres agents IA peuvent l’amplifier. Plus d’agents peuvent commenter, réagir et optimiser. Un appel à l’action est cliqué, une réunion est réservée, et la personne qui rejoint cet appel est accueillie par un agent commercial IA. De l’extérieur, tout semble positif. L’engagement est en hausse. L’activité est en hausse. La productivité semble plus élevée. Mais si l’on prend le temps de ralentir, ces systèmes ne font que discuter entre eux.

Le nouveau fossé de confiance

Les médias sociaux étaient déjà saturés de bruit produit par des personnes. L’IA agentique amplifie cela à l’échelle du cloud, avec une rapidité sans précédent. Les marques et les influenceurs automatisent les réactions et les commentaires pour favoriser les algorithmes. Ces gains s’érodent à mesure que la confiance s’érode. Lorsque les utilisateurs ne peuvent pas dire si un compte, un article ou un commentaire provient d’une personne, cela renforce leur scepticisme existant et inspire un nouveau scepticisme chez ceux qui sont habituellement réceptifs.

Les problèmes de fiabilité persistants dans l’IA générative continuent de mettre à mal la confiance. PwC souligne un fossé de confiance croissant alors que les organisations adoptent l’IA plus rapidement qu’elles ne peuvent la gouverner avec la transparence, la responsabilité et le contrôle appropriés.

Gouvernance comme code, pas seulement politique

Les dirigeants ne peuvent pas résoudre ce problème avec des déclarations audacieuses, ni une politique de confidentialité ou de sécurité de l’information ne peut réduire les dangers d’une IA non gouvernée. La gouvernance doit vivre à l’intérieur de l’architecture administrative, opérationnelle et technique des solutions utilisant l’IA. Les organisations qui réussissent sont celles qui intègrent l’intention dans le système lui-même, ce qui signifie des contrôles audités, des invites versionnées, une approbation humaine avant que des actions externes ne soient effectuées, et des journaux d’activité qui peuvent se défendre en justice.

La responsabilité du conseil d’administration

Alors que de nombreux entrepreneurs considèrent comment l’IA agentique aide au marketing ou aux ventes, il s’agit d’un enjeu de niveau conseil, tout comme la cybersécurité ou la conformité. Des conseils bien gouvernés définissent ce qui est permis, établissent des protocoles d’escalade et exigent des preuves de contrôle.

Conclusion

L’IA agentique introduit tous les risques que les professionnels de la sécurité exécutive sont formés à gérer, mais elle exige également une discipline opérationnelle de niveau exécutif. Les projets ont besoin de propriété définie, de contrôle des modifications et de clôture. Chaque agent doit avoir un dossier de construction, un enregistrement de test et un plan de retour en arrière. La conformité sera la norme lorsque les régulateurs demanderont comment vos systèmes IA se comportent.

Les entreprises qui s’adaptent tôt traiteront l’IA agentique comme une discipline opérationnelle, en appliquant une rigueur de gestion de projet, une architecture de sécurité, et un examen juridique avant le déploiement. L’automatisation n’est pas une solution rapide ; elle nécessite soin et conformité.

La culture de l’extension de ce qui est possible doit se poursuivre. L’IA doit rendre les gens plus rapides, pas invisibles. L’objectif n’est pas d’éliminer le jugement humain, mais de l’amplifier.