Les groupes de défense des droits avertissent que l’IA en Inde alimente la haine

Alors que des responsables gouvernementaux indiens se réunissent pour le Sommet sur l’Impact de l’IA 2026, deux organisations de la société civile ont publié un rapport avertissant que le modèle de gouvernance de l’intelligence artificielle en Inde risque d’enraciner la discrimination et d’accélérer l’érosion démocratique.

Analyse du rapport

Le rapport, intitulé Gouvernance de l’IA à la limite du recul démocratique, soutient que l’approche réglementaire de New Delhi repose fortement sur la conformité volontaire et l’auto-régulation de l’industrie, tout en évitant des mécanismes de responsabilité contraignants. Le ministère indien de l’Électronique et des Technologies de l’Information a émis des lignes directrices sur la gouvernance de l’IA en novembre 2025, affirmant qu’une loi distincte sur l’IA n’est pas nécessaire pour le moment. Au lieu de cela, les dommages potentiels devraient être abordés sous la législation existante, telle que la Loi sur la Technologie de l’Information de 2000 et le nouveau code pénal indien, la Bharatiya Nyaya Sanhita de 2023.

Manque de transparence et risques pour les communautés vulnérables

Le rapport souligne que ce cadre manque de normes de transparence obligatoires, d’audits indépendants et de règles de responsabilité claires. Bien que le message officiel du sommet mette l’accent sur la démocratisation de l’IA, les auteurs affirment que les communautés vulnérables, y compris les minorités religieuses et sociales, restent largement ignorées dans la conception des politiques. Ils mettent en garde contre l’opacité algorithmique, qui rend difficile pour les groupes marginalisés de contester les décisions automatisées devant les tribunaux.

Propagation de la propagande et surveillance accrue

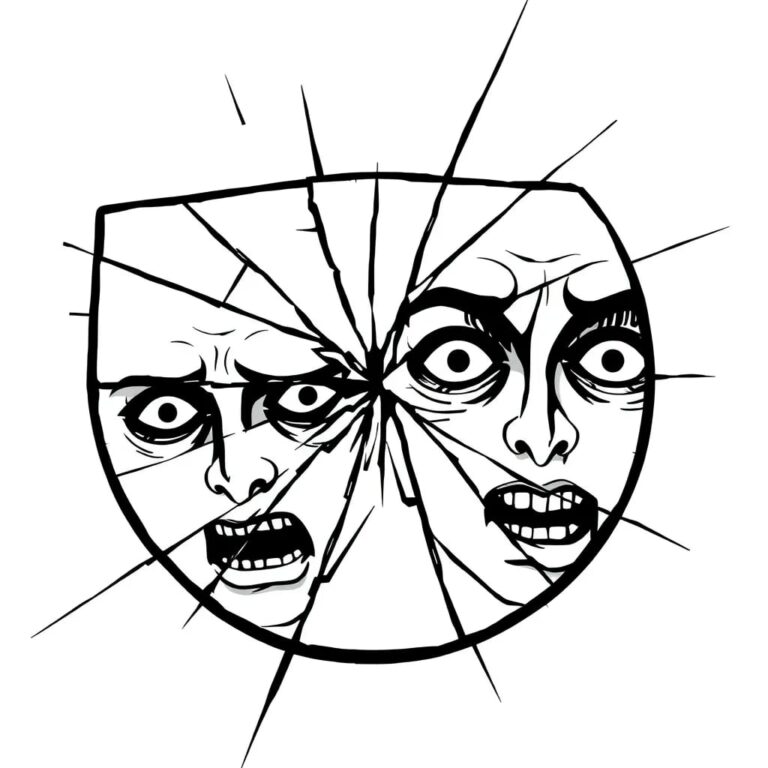

Le rapport documente des cas où des outils d’IA générative ont été utilisés pour diffuser de la propagande communautaire, y compris des vidéos et des images générées par l’IA ciblant des communautés spécifiques. Les chercheurs lient ce contenu synthétique à des narrations plus larges, souvent utilisées pour dépeindre certaines communautés comme des menaces démographiques ou culturelles. De plus, l’utilisation croissante de l’IA dans la police et la surveillance est préoccupante. Par exemple, des outils d’IA ont été proposés pour identifier des immigrés présumés sur la base de profils linguistiques, une mesure qui pourrait permettre un ciblage ethnique ou religieux.

Conclusion et recommandations

Alors que des délégués du monde entier discutent d’innovation et de croissance, le rapport appelle à une surveillance contraignante, à des protections pour les minorités et à des limites claires sur la surveillance biométrique. Il met en garde que, sans protections applicables, l’expansion de l’IA en Inde pourrait renforcer les hiérarchies existantes de caste, de religion et de pouvoir politique au lieu de réduire les divisions technologiques.